Para procesar textos con el objetivo de extraer información sobre personas y datos asociados utilizando un modelo transformer, como los de la familia BERT o GPT, se puede seguir los siguientes pasos:

1. Definir el objetivo

Decidir qué tipo de información extraer del texto. Por ejemplo:

- Entidades nombradas: nombres de personas, lugares, fechas, números de teléfono.

- Relaciones entre entidades: por ejemplo, quién trabaja para quién.

- Características de personas: edad, dirección, profesión.

2. Elegir un modelo adecuado

Elegir un modelo dependiendo de las necesidades:

- NER (Reconocimiento de Entidades Nombradas):

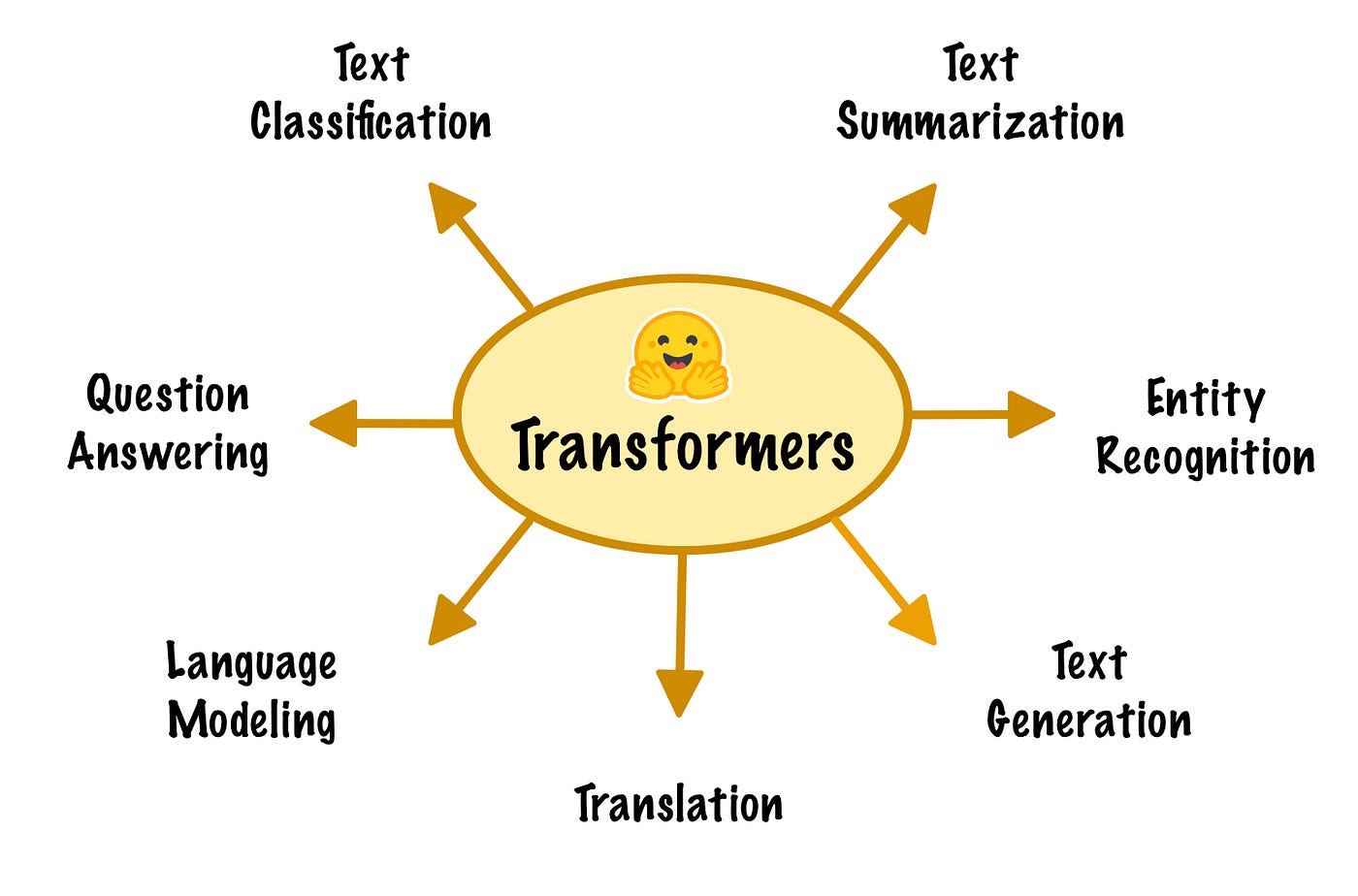

Usa un modelo preentrenado como

BERToRoBERTay ajustado para NER. - QA (Question Answering): Para plantear preguntas al modelo sobre el texto.

- Clasificación/Segmentación de texto: Para extraer datos específicos, se puede entrenar un modelo para identificar las entidades que nos interesan.

Modelos recomendados:

- SpaCy: Una biblioteca práctica con modelos NER listos para usar.

- Hugging Face Transformers: Ofrece modelos preentrenados y ajustes para tareas específicas.

3. Preparar el texto

Antes de procesar el texto, es necesario limpiarlo y preprocesarlo:

- Limpieza básica:

- Elimina caracteres no deseados (por ejemplo, emojis, HTML).

- Estándariza el formato (como mayúsculas/minúsculas).

- Tokenización: Utiliza una tokenización adecuada al transformer (como WordPiece para BERT).

4. Configurar el pipeline de procesamiento

Con Hugging Face se puede usar un pipeline para extraer información con modelos preentrenados.

Ejemplo: Reconocimiento de entidades nombradas (NER)

No hay comentarios:

Publicar un comentario